Forfattere

Vi bruger automatisk mere end én af vores sanser til at forstå verden omkring os. Når vi har en samtale, bruger de fleste af os vores ører til at lytte til, hvad andre mennesker siger. Men du vil måske blive overrasket over at vide, at det, du ser, også er meget vigtigt for at kunne forstå andre. Denne artikel ser på, hvordan hørelse og syn kombineres, og forklarer, hvordan begge disse sanser hjælper os med at forstå tale. Vi demonstrerer, hvor vigtigt det er at se ansigterne på folk, der taler, især når vi befinder os på støjende steder. Dette emne har vigtige implikationer for brugen af ansigtsmasker! Det er virkelig vigtigt, at vi tænker over, hvordan ansigtsmasker kan påvirke menneskers evne til at kommunikere med hinanden.

Har du nogensinde svært ved at forstå, hvad dine venner eller lærere siger, når de har ansigtsmasker på? Hvorfor er det sådan? Næsten alle har gavn af at se folks ansigter, når de taler. De forskellige lyde, folk laver, når de taler, kræver, at de bevæger munden på unikke måder, og selvom du måske ikke er klar over det, forstår din hjerne disse specifikke mundformer! Formerne gør det lettere for os at forstå folk, når vi kan se dem tale.

Hjernen har specialiserede områder, der behandler information fra sanserne og giver os mulighed for at forstå verden. Nogle af disse hjerneområder kombinerer automatisk information på tværs af flere sanser. Når information fra én sans (f.eks. hørelsen) er upålidelig, så stoler vi automatisk mere på information fra en anden sans (f.eks. synet). Det er derfor, du især vil bemærke fordelene ved at se folk tale, når du er på et støjende sted.

I denne artikel vil vi begynde med at introducere dig til forskellen mellem sansning og perception, og vi vil bruge en velkendt visuel illusion til at demonstrere, hvordan perception nogle gange kan være unøjagtig. Det vil hjælpe dig til at forstå, at det, du opfatter, ikke nødvendigvis svarer til den information, der er i verden. Vi vil derefter forklare, hvordan vores hjerner kombinerer information på tværs af forskellige sanser, især syn og hørelse.

Dine ører opfanger lydbølger, og du hører dem som lyd. Dine øjne opfanger lysenergi, som giver dig synet. Vi kalder disse processer sensation. Det, din hjerne derefter gør med informationerne fra dine sanser, kaldes perception. Det meste af tiden antager vi, at det, vi sanser, og det, vi opfatter, er det samme. Men nogle gange kommer vores hjerner til de forkerte konklusioner om, hvad der er derude! Perception kan være et vanskeligt job: Det indebærer at kombinere det, vores sanser fortæller os, med det, vi allerede ved om verden, for at få det bedst mulige gæt på, hvad der sker. Vi kan misforstå eller fejlfortolke sanseindtryk og så opfatte noget, som bare ikke er sandt.

Visuelle illusioner kan være fascinerende at se på, og de giver os et rigtig godt eksempel på, hvordan hjernen nogle gange kan fejlfortolke sanseindtryk og give os den forkerte opfattelse. Tag et kig på figur 1. Hvilken bil tror du er den største? Tag nu en lineal frem og mål dem. Havde du ret?

Ved første øjekast tror du måske, at den øverste bil er større end den nederste, men de er faktisk lige store! Vi kalder dette en visuel illusion, fordi billedet narrer din hjerne til at tro, at bilerne er forskellige størrelser. Det fungerer, fordi spor i billedet (vejens form i dette eksempel) får den øverste bil til at se ud til at være længere væk end den nederste bil. Normalt ser ting, der er langt væk, mindre ud end ting, der er tæt på os (næste gang du er på en biltur, så se på størrelsen af bilerne i det fjerne sammenlignet med dem tæt på), så bilen øverst på vejen burde se mindre ud, fordi den er længere væk. På en eller anden måde ved hjernen dette, så den “opskalerer” automatisk opfattelsen af bilens størrelse. I det virkelige liv fungerer denne mentale justering normalt godt og hjælper vores opfattelse af verden til at give mening.

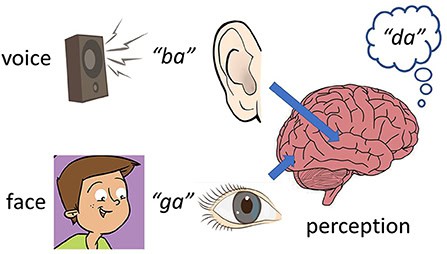

Vi ved, at vores hjerner ofte bruger både syn og hørelse til at forstå verden. Det kan gøre det lettere for vores hjerne at afgøre, hvad der foregår, end hvis vi kun brugte én sans. Men på samme måde som en visuel illusion kan spille hjernen et puds via øjnene, kan en audiovisuel illusion forvirre opfattelsen, hvis informationerne fra hørelsen og synet ikke stemmer overens. Dette blev illustreret af et eksperiment udført af Harry McGurk og John McDonald i 1976 [1]. Disse forskere optog en person, der sagde lyden “ba”. Derefter lavede de en stum video af den samme person, der sagde lyden “ga”. De afspillede lydoptagelsen (“ba”) sammen med videoen (“ga”) og bad frivillige om at sige, hvilken lyd de hørte. Du bliver måske overrasket over at høre, at de fleste frivillige sagde, at de hørte lyden “da”! Det skyldes, at deres hjerner blandede det, de så og hørte, sammen og gættede på, hvad lyden egentlig var. Det fantastiske ved dette eksperiment er, at det virkelig ændrer den måde, ordene lyder på, hvilket kaldes McGurk-effekten. (figur 2). Eksperimentet viste, at det at se et talende ansigt kan have en stærk effekt på de lyde, folk opfatter1. Effekten findes også med andre kombinationer af lyde. Opfattelsen af tale er i virkeligheden resultatet af, at hjernen gør sit bedste gæt ud fra det, vi ser, det, vi hører, og det, vi allerede ved om sprog.

I den virkelige verden matcher læbernes bevægelser normalt de lyde, der kommer fra folks munde, så at se nogen tale hjælper os normalt med at opfatte det rigtige ord. Denne visuelle information har en tendens til at være mere nyttig til at forstå tale, når samtalen finder sted i støjende omgivelser. Prøv at sidde i et stille rum sammen med en ven. Du vil sandsynligvis finde det ret nemt at forstå, hvad din ven siger. Tænd nu for fjernsynet med høj lydstyrke. Hvor let er det at forstå din ven nu? Det er meget sværere at høre og forstå, hvad nogen siger, hvis baggrunden er meget støjende. Hvis du ser på din vens ansigt og læber, er der større sandsynlighed for, at du gætter rigtigt på, hvad der bliver sagt.

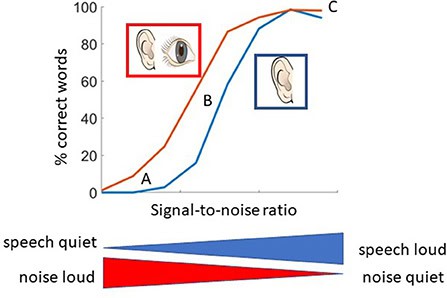

Vi udførte nogle eksperimenter om, hvordan baggrundsstøj påvirker forståelsen af en sætning [2]. Først filmede og optog vi en frivillig, der sagde flere forskellige sætninger (såsom “En stor størrelse i sko er svær at sælge.”). Derefter afspillede vi disse optagelser for andre frivillige og bad dem gentage, hvad de hørte, og vi talte, hvor mange ord de fik rigtigt. Vi gentog dette eksperiment med mange frivillige, tilføjede forskellige niveauer af baggrundsstøj eller reducerede lydstyrken af talesignalet. Forholdet mellem talesignalet og baggrundsstøjen kaldes signal-to-noise ratio. Nogle gange afspillede vi kun lyden af den person, der talte, og andre gange viste vi også videoen af personen, så de frivillige både kunne se og høre den talende person.

Vi plottede de indsamlede oplysninger ind i en graf (figur 3). Når baggrundsstøjen var meget højere end den person, der talte, kunne vores frivillige ikke identificere nogen ord korrekt. Men når sætningerne var højere end baggrundsstøjen, hørte vores frivillige de fleste af ordene korrekt. Mellem disse to situationer kunne de frivillige identificere nogle, men ikke alle ordene korrekt. Vores resultater viser tydeligt, at folk kan forstå tale med mere baggrundsstøj til stede, hvis de kan se talernes ansigter. Denne effekt forklarer din oplevelse af at høre bedre, når du kan se folk tale, især når du befinder dig på et støjende sted. Tidligere undersøgelser har fundet lignende resultater [3].

Hvorfor er det vigtigt? Forestil dig, at du arbejder på en støjende fabrik med larmende, farlige maskiner. Forestil dig nu, at din kollega forsøger at forklare dig præcis, hvordan du bruger en maskine. Med al den støj i baggrunden, tror du så, at du ville være i stand til at høre instruktionerne tydeligt? Hvad nu, hvis din kollega havde en sikkerhedsmaske på, mens han talte? I et sådant miljø kan det være meget farligt at begå en fejl, og det kan endda resultere i skader.

Har du nogensinde prøvet at forstå, hvad nogen siger, ved bare at se på deres ansigt uden at høre, hvad de siger? Du vil måske opdage, at du er bedre til denne opgave, hvis du har dårligere hørelse. Mennesker, der er døve eller har nedsat hørelse, er generelt bedre til mundaflæsning end folk med normal hørelse [4]. Denne evne udviklede sig sandsynligvis over tid, da disse mennesker mistede deres hørelse og var nødt til at være mere opmærksomme på deres andre sanser.

Under coronavirus-udbruddet var det ofte et krav at bære mundbind. Masker gør mundaflæsning meget vanskelig for folk, der har brug for det. I Storbritannien hjalp kampagnefolk med at overtale regeringen til at levere gennemsigtige ansigtsmasker for at hjælpe døve med at kommunikere. I vores forskning forsøger vi at forstå, hvordan mundaflæsning hjælper kommunikation, og især hvordan det hjælper mennesker med høreproblemer.

Visuel information er virkelig vigtig for at hjælpe os med at forstå de lyde, vi hører. Det, vi ser, er især vigtigt for at forstå tale, når den lyd, vi lytter til, er påvirket af enten baggrundsstøj eller dårlig hørelse. Der er stadig meget, vi ikke forstår om, hvordan hjernen kombinerer det, vi ser, og det, vi hører. Næste gang du befinder dig i et støjende miljø, så tænk over, hvor afhængig du er af at se ansigterne på dem, der taler, og hvad der kan gøres for at gøre visuel taleinformation mere tilgængelig for folk, der har problemer med at høre.

Sansning: Den proces, hvor vores sanser opfanger information i verden.

Perception: Den proces, hvor vores hjerner giver mening til de informationer, vi får fra sanserne.

McGurk-effekten: En audiovisuel illusion, der opstår, når man hører en lyd (f.eks. “ba”) og samtidig ser de mundbevægelser, der ledsager en anden lyd (f.eks. “ga”), hvilket resulterer i opfattelsen af en ny lyd (f.eks. “da”).

Signal-til-støj-forhold: Et mål for styrken af “signalet” (i vores tilfælde tale) i forhold til baggrundsstøjen.

Læbelæsning: Forståelse af tale ud fra mundbevægelser alene.

[1] ↑ McGurk, H., og MacDonald, J. 1976. At høre læber og se stemmer. Nature 264:746-8.

[2] ↑ Stacey, P. C., Kitterick, P. T., Morris, S. D. og Sumner, C. J. 2016. Bidraget fra visuel information til opfattelsen af tale i støj med og uden informativ temporal finstruktur. Hear. Res. 336:17-28. doi: 10.1016/j.heares.2016.04.002

[3] ↑ Sumby, W. H., og Pollack, I. 1954. Visuelt bidrag til taleforståelighed i støj. J. Acoust. Soc. Am. 26:212-5.

[4] ↑ Schreitmüller, S., Frenken, M., Bentz, L., Ortmann, M., Walger, M. og Meister, H. 2018. Validering af en metode til vurdering af mundaflæsning, audiovisuel forstærkning og integration under talemodtagelse med cochlear-implanterede og normalthørende personer ved hjælp af et talende hoved. Ear Hear. 39:503-16. doi: 10.1097/AUD.0000000000000502

Mennesker har lavet musik i titusinder af år. Men hvad sker der i din hjerne, når du lytter til dit yndlingsband eller din yndlingsmusiker? I denne artikel følger du lydens rejse fra ørerne til hjernen, hvor forskellige områder arbejder sammen, mens du lytter til musik. Musik involverer mange hjernefunktioner, såsom lydbehandling, hukommelse, følelser og bevægelse. Du vil også opdage, at hjernen kan lære at genkende velkendte mønstre i musik, hvilket kan hjælpe med at forklare, hvorfor musik kan gøre os glade, triste eller endda ophidsede. Til sidst vil du udforske, hvad der sker i musikeres hjerner, når de spiller på deres instrumenter.

…Kunstig intelligens (AI) systemer bliver ofte rost for deres imponerende præstationer inden for en lang række opgaver. Men mange af disse succeser skjuler et fælles problem: AI tager ofte genveje. I stedet for virkelig at lære, hvordan man udfører en opgave, bemærker den måske bare enkle mønstre i de eksempler, den har fået. For eksempel kan en AI, der er trænet til at genkende dyr på fotos, stole på baggrunden i stedet for selve dyret. Nogle gange kan disse genveje føre til alvorlige fejl, såsom en diagnose fr , der er baseret på hospitalsmærker i stedet for patientdata. Disse fejl opstår selv i avancerede systemer, der er trænet på millioner af eksempler. At forstå, hvordan og hvorfor AI tager genveje, kan hjælpe forskere med at designe bedre træningsmetoder og undgå skjulte fejl. For at gøre AI mere sikker og pålidelig skal vi hjælpe den med at udvikle en reel forståelse af opgaven – ikke bare gætte ud fra mønstre, der har fungeret tidligere.

…Er du nogensinde faldet og slået hovedet, mens du legede? Følte du dig lidt svimmel og havde ondt i hovedet? Hvis ja, kan du have fået en hjernerystelse! Hjernerystelser kan ske hvor som helst. De kan ske under sport, når du leger med dine venner eller endda når du cykler med dine forældre. Det kan være svært at vide, om du har fået en hjernerystelse. Mange børn og forældre er ikke sikre på, hvad de skal gøre, hvis nogen får en hjernerystelse. Læger og forskere ved, at det hjælper dig med at komme dig hurtigere, hvis du gør det rigtige efter en hjernerystelse. Denne artikel forklarer, hvad en hjernerystelse er. Den hjælper dig med at se, om du eller en ven har fået en hjernerystelse, og fortæller dig, hvad du skal gøre, hvis du nogensinde får en hjernerystelse.

…Hjertet er en meget vigtig muskel, der arbejder uafbrudt for at pumpe blod og levere vigtige næringsstoffer og ilt til alle dele af kroppen. Denne artikel ser på, hvordan hjertet fungerer normalt, og hvad der sker, når det fungerer unormalt, som det er tilfældet med en tilstand kaldet atrieflimren (AF). AF er en almindelig tilstand, der opstår, når hjertet slår uregelmæssigt og ude af takt. AF kan øge en persons risiko for at udvikle alvorlige problemer som hjertesvigt eller slagtilfælde. Denne artikel ser også på, hvordan AF kan diagnosticeres, hvad der forårsager AF, og de forskellige måder, det kan behandles på.

…